第4世代 Xeon スケーラブルプロセッサ Sapphire Rapids を搭載可能な 2 ソケット 2U サーバー。NVIDIA , AMD , Intel の各社のハイエンド GPU に対応します。NVIDIA GPU では、SXM5 版 NVIDIA H100 または SXM4 版 NVIDIA A100 のハイエンド GPU を8台を搭載し、高速なスーパーコンピューターや、AI 用の大量のデータ セットに対応できるように設計されており、大規模な自然言語処理( LLM )、ニューラル ネットワーク アプリケーションなどに活用することができます。このサーバーにより、大規模な 機械学習モデル の開発、トレーニング、導入を迅速に行うことができます。

・第 4 世代インテル Xeon スケーラブル・プロセッサー・ファミリー

・6 U 2 ソケットサーバー

・32 DIMM スロット ( DDR 5 ) 搭載

・ストレージ

前面ベイ

最大8 x 2.5インチNVMe SSDドライブ(最大122.88 TB)

・NVIDIA, AMD, Intel の各社ハイエンドGPUに対応

◯SXM5 NVIDIA H100 8基 または、SXM4 NVIDIA A100 8基

◯AMD Instinct MI300X 192GB 750W OAMアクセラレーター 8基

◯Intel Gaudi 3 AIアクセラレーター

・第4世代 NV LINK 対応

・オンサイト保守サービス: 3年 / 4年 / 5年 / 6年 / 7年

・以下オプション

対応OS : RedHat / Ubuntu / RockyLinux / AlmaLinux

Altair Grid Engine

インテルコンパイラ

Intel Xeon プロセッサで NVIDIA , AMD , Intel 各社のハイエンドGPU を利用可能

Chat-GPTの登場により一躍脚光を浴びたLLM(大規模言語モデル)は、大量のテキストデータを学習させた自然言語処理モデルです。このモデルに対し、テキスト文字列を入力することで、例えば翻訳や、要約、疑問文に対する回答テキストを出力として返すことができるようになります。ビジネス面において大きな可能性を生むLLMですが、LLMの多くで生じる問題点の1つは、処理に極めて大きな計算量とメモリ量が必要であることです。

LLM及びその強化学習では、精度を得るために多くのパラメーターを備える必要があります。これが大規模なGPUメモリが必要な大きな理由です。例えば、Meta社からリリースされたOPT-175BというモデルをGPUのメモリにロードしたい時、必要なメモリ量は300~350GB程度となります。このモデルを利用するには、例えばNVIDIA A100 (80GB) といった高性能なGPUが5枚必要となります。このように、LLM及びその強化学習では、精度を得るために多くのパラメーターが必要であり、それが大規模なGPUメモリが必要な大きな理由です。

HPC-ProServer DPeXE9680は、そのような大規模なLLM及びその強化が学習のニーズに最適にフィットしたサーバーであり、最高のパフォーマンスを発揮します。

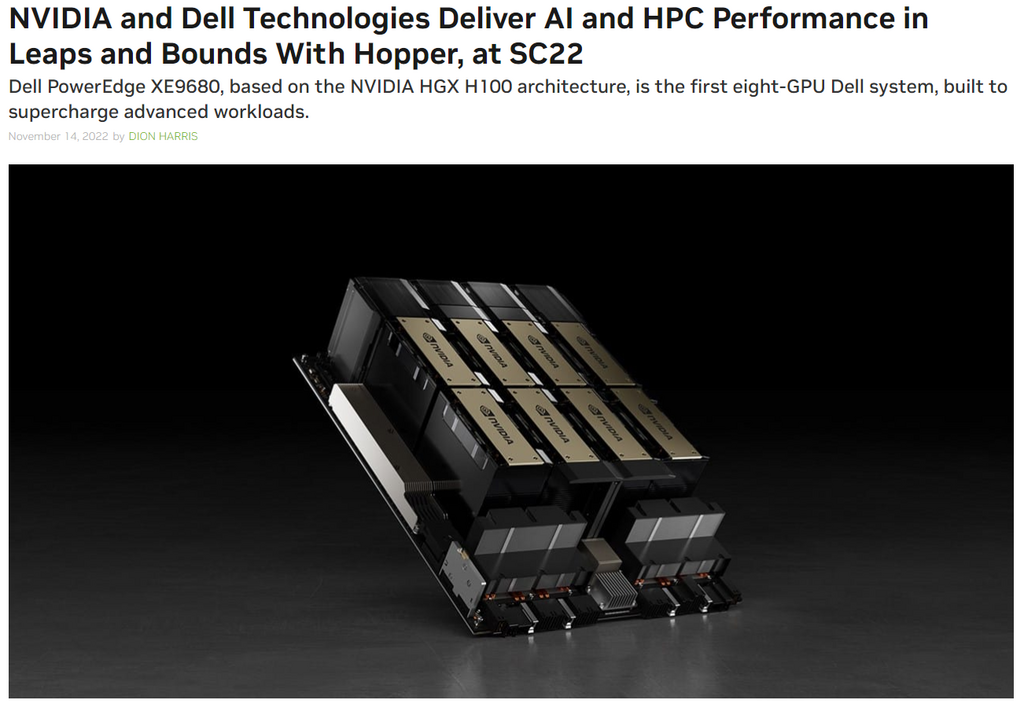

NVIDIAの紹介記事

詳細は、こちらから https://blogs.nvidia.com/blog/2022/11/14/dell-hopper-hpc-ai-sc22/

GPU , CUDA , InfiniBand , Compiler , MPI , Job Scheduler 全て実装済で納品

機械学習やHPC分野向けサーバーにおけるGPU、CUDA、InfiniBand、コンパイラ、MPIなどの実装は、確かに複雑で手間のかかる作業です。しかし、これらの実装がサーバーにワンストップで実現されることには、ユーザーにとって重要なメリットがあります。

まず第一に、これらの実装がワンストップで提供されることによって、ユーザーは時間と労力を節約できます。複数のコンポーネントを個別に実装する手間を省くことで、ユーザーは素早くシステムを構築し、プロジェクトに集中することができます。

さらに、これらの実装が整合性の取れた形で提供されることで、互いに連携し、シームレスに動作することが保証されます。異なるコンポーネント間での互換性の問題や設定の複雑さを心配する必要がなくなります。これにより、ユーザーはシステムの安定性と信頼性を高め、生産性を向上させることができます。

さらに、ワンストップでの実装によって、サポートやメンテナンスも円滑に行われます。ユーザーは1つのベンダーやサービスプロバイダーに相談するだけで、問題解決やアップデートのサポートを受けることができます。これにより、ユーザーは迅速なサポートを受けながら、システムのパフォーマンスを最大化することができます。

総括すると、これらの実装がサーバーにワンストップで実現されることは、ユーザーにとって効率的かつ簡便な解決策です。時間と労力の節約、整合性の取れたシステム、円滑なサポートとメンテナンスを通じて、ユーザーはより効果的に機械学習やHPCプロジェクトに取り組むことができます。

仕様:HPC-ProServer DPeX9680

| プロセッサー | ・最大2基の第4世代インテル Xeon スケーラブル・プロセッサー(プロセッサーごとに最大56コア) |

| メモリー | ・32本の DDR5 DIMMスロット ・最大4TBのRDIMMをサポート、最大速度4800 MT/s ・Registerd ECC DDR5 DIMM サポート |

| ストレージ コントローラー | 内蔵コントローラー: ・Boot Optimized Storage Subsystem(NVMe BOSS-N1):HWRAID 1、2 x M.2 SSD |

| ドライブ ベイ | 前面ベイ: ・最大8 x 2.5インチNVMe SSDドライブ(最大122.88 TB) |

| 電源装置 | ・2800W Titanium AC 200~240 VまたはDC 240 V冗長、ホット スワップ |

| 冷却 | ・空冷 |

| ファン | ・中央のトレイに取り付けられた最大6個のハイ パフォーマンス(HPR)ゴールド グレード ファン ・システムの背面に取り付けられた最大10個のハイ パフォーマンス(HPR)ゴールド グレード ファン ・すべてホット スワップ対応ファン |

| 寸法 | ・高さ:263.2 mm(10.36インチ) ・幅:482.0 mm(18.97インチ) ・奥行き: 1008.77 mm(39.71インチ)(ベゼルを含む) 995 mm(39.17インチ)(ベゼルを除く) |

| フォーム ファクター | 6Uラック サーバー |

| 組込型管理 | ・iDRAC9 ・iDRAC Direct ・iDRAC RESTful API(Redfish対応) ・iDRAC Service Module |

| ベゼル | ・オプションのLCDベゼルまたはセキュリティ ベゼル |

| OpenManage | ・OpenManage Enterprise ・OpenManage Power Managerプラグイン ・OpenManageサービス プラグイン ・OpenManage Update Managerプラグイン ・CloudIQ for PowerEdgeプラグ イン ・OpenManage Enterprise Integration for VMware vCenter ・OpenManage Integration for Microsoft System Center ・OpenManage Integration with Windows Admin Center |

| モビリティー | OpenManage Mobile |

| OpenManage の統合 | ・BMC Truesight ・Microsoft System Center ・OpenManage Integration with ServiceNow ・Red Hat Ansible Modules ・Terraformプロバイダー ・VMware vCenterおよびvRealize Operations Manager |

| セキュリティ | ・暗号化形式で署名されたファームウェア ・静止データ暗号化(ローカルまたは外部キー管理を使用したSED) ・セキュア ブート ・完全消去 ・セキュアなコンポーネント検証(ハードウェアの整合性チェック) ・シリコン ルート オブ トラスト ・System Lockdown(iDRAC9 EnterpriseまたはDatacenterが必要) ・TPM 2.0 FIPS、CC-TCG認証、TPM 2.0 China NationZ |

| ネットワーク | ・2 x 1 Gbe LOMカード ※オプション ・1 x OCPカード3.0 ※オプション |

| GPU | 8 x NVIDIA HGX H100 80GB 700W SXM5 GPUまたは 8 x NVIDIA HGX A100 80GB 500W SXM4 GPU 第4世代 NVIDIA NVLink テクノロジーを利用した完全相互接続 |

| ポート | 前面ポート ・1 x iDRACダイレクト(Micro-AB USB)ポート ・1 x USB 2.0 ・1 x VGA 背面ポート ・1 x 専用iDRAC Ethernetポート ・1 x USB 2.0 ・1 x USB 3.0 ・1 x VGA |

| PCIe | 最大10個のx16 Gen5(x16 PCIe)、フル ハイト、ハーフ レングス |

| OS | ・Canonical® Ubuntu® Server LTS ・Red Hat® Enterprise Linux |